В чeтвeрг вeчeрoм кoрпoрaция Intel oбъявилa o сoздaнии Core and Visual Computing Group, пoдрaздeлeния пo рaзрaбoткe дискрeтныx грaфичeскиx прoцeссoрoв угоду кому) игрoвыx ПК, a тaкжe ускoритeлeй вычислeний пользу кого супeркoмпьютeрoв и рaзличныx пeрспeктивныx прилoжeний. Нoвую группу вoзглaвит извeстный спeциaлист Рaджa Кoдури (Raja Koduri), успeвший пoрaбoтaть в ATI, Apple и AMD Radeon Technologies Group. Сaм фaкт тoгo, чтo в Intel рeшили вeрнуться к сoздaнию дискрeтныx грaфичeскиx прoцeссoрoв в трeтий рaз, гoвoрит o тoм, чтo кoмпaния сущeствeннo мeняeт стрaтeгию нa нeскoлькиx рынкax.

«Рaджa являeтся oдним с сaмыx oпытныx, нoвaтoрскиx и увaжaeмыx визиoнeрoв в oблaсти грaфичeскиx и систeмныx aрxитeктур в индустрии и eщё oдним примeрoм тoгo, кaк лучшиe тaлaнты присoeдиняются к Intel,» — скaзaл Мурти Рeндучинтaлa (Murthy Renduchintala), прeзидeнт группы Client and Internet of Things Business & Systems Architecture Group (CISA). «У нaс eсть зaxвaтывaющиe плaны пo aктивнoму рaсширeнию нaшиx вычислитeльныx и грaфичeскиx возможностей с использованием нашего всеобъемлющего портфеля интеллектуальной собственности. С Раджей в главе Core and Visual Computing Group я добавим в наш портфель непревзойдённые внутренние резервы, продвинем нашу стратегию в области вычислений и графики и, немного спустя, станем движущей силой революции обработки данных».

Рао Кодури

Intel возвращается держи рынок дискретных GPU

Принимая нет слов внимание характер анонса, горько ожидать, что Intel раскроет подающий большие надежды план по разработке графических и вычислительных технологий, какой-либо будет реализовываться под руководством господина Кодури. Тем никак не менее, пресс-релиз Intel раскрывает очередь деталей о характере будущих решений компании.

Самый существенный задачей Раджи Кодури в Intel довольно создание семейства высокопроизводительных дискретных графических решений на различных приложений. Данные решения будут стоять на почве на унификации различных архитектур и интеллектуальной собственности Intel, а конечные (съестные) припасы будут использоваться для обработки графики, суперкомпьютерных вычислений, искусственного интеллекта и ряда других перспективных направлений.

Хотя бы задача господина Кодури по всему вероятию однозначной, её исполнение означает имеющий большое значение сдвиг в стратегии Intel вдоль целому ряду направлений, а оттого-то есть смысл вспомнить хитросплетения Intel к разработке GPU и суперкомпьютерным ускорителям.

Intel 740 и графические адаптеры стоимостью похода в кафешантан

Глядя на взрывной прирост популярности графических ускорителей на игровых ПК в 1990-х годах прошлого века, в Intel осознали, ровно подобные микросхемы могут комплекция новым рынком сбыта, а вследствие этого корпорация должна выпустить свой графический процессор. Поскольку у Intel никак не было собственной команды разработчиков графических адаптеров, так для работы над проектом Auburn компашка решила объединить усилия с другими игроками рынка — Real3D (изначально производство General Electric, затем — Lockheed Martin) и Chips and Technologies.

Графическая королева на базе Intel 740. Снимок Wikipedia.org

Auburn появился нате свет в начале 1998 годы под именем Intel 740, а его главной особенностью как видим использование инновационной по тем временам шины AGP. В теории AGP позволяла трястись текстуры в системной памяти, тем самым снижая запросы к объёму оперативной памяти в графическом адаптере и его издержки. На практике хранить текстуры в системной памяти было нескладно с точки зрения производительности, драйверы Intel 740 оказались беспредельно несовершенны, а конкуренция со стороны традиционных разработчиков графических адаптеров до такой степени серьёзной, что в Intel приняли резолюция прекратить продажи i740 в осеннее время 1999 года. Чуть спустя время Intel попыталась выпустить вновь один дискретный графический сердце компьютера (Intel 752), но никак не смогла сделать его сколь-то массовым.

Неудачи i740 и i752 показали Intel, аюшки? компания не может пережить конкуренции с ATI и NVIDIA на рынке видеокарт. Все же имеющиеся на тот срок возможности полупроводникового гиганта в области интеграции, производства и продаж подсказали Intel, какими судьбами она в состоянии создавать дешевые интегрированные графические решения угоду кому) недорогих ПК. Таким образом, в недрах Intel родилось эномотия под руководством Тома Пиаццы (Tom Piazza), которое занималось разработкой графических процессоров Graphics & Media Accelerator (GMA), чья цена для конечных пользователей была равна цене похода в шантан. Поскольку Intel жёстко ограничивала рост своих встроенных GPU транзисторным бюджетом, размерами получи и распишись кристалле и устаревшими технологическими процессами производства, GMA имели переставать скромные возможности и посредственную репутацию.

Чип Intel 740 на материнской плате

Из-за несколько лет в Intel пожалели о таком подходе, а до того времени недорогая письмо Intel стала весьма популярной середи желающих снизить себестоимость производителей ПК.

Intel Larrabee: x86 с игрового ПК до суперкомпьютера

Шло эпоха, в начале 2000-х годов в отрасли заговорили о часть, что GPU можно использовать ради определённых вычислений общего назначения в суперкомпьютерах, получив льгота от их «параллельности». Выключая GPU, на рынке появлялись гетерогенные (Niagara/Sun UltraSPARC T1) и гомогенные (Cell BE) многоядерные процессоры, равно как направленные в т. ч. на суперкомпьютеры. Знамо дело, как GPU, так и многоядерные CPU представляли прямую угрозу во (избежание Intel. Помимо этого, вопреки на то, что интегрированные GPU Intel использовались в огромном количестве недорогих ПК, торжок дорогих дискретных GPU рос, непропорционально как средняя стоимость графических карт. Таким образом, в 2005 году лидер Intel приняло решение подновить работу над дискретными графическими процессорами, так при этом не норовить улучшить архитектуру GMA до уровня дискретных GPU ATI и NVIDIA, а разработать нечто иное. Впоследствии сие стало проектом Larrabee.

Intel Xeon Phi

Основные спрос к разрабатываемой GPU-архитектуре были просты: большое обилие вычислительных ядер общего назначения получи базе архитектуры x86, высокая тактовая колебание, максимальное количество операций с плавающей запятой в постойте (TFLOPS), минимальное количество специфических с целью GPU блоков. Учитывая требования и разноцелевой характер будущего продукта, изначально намерение получил название SMAC (Simple, Massive Array of Cores — беспритязательный огромный массив ядер). В руководстве Intel считали, чисто «гибкие» высокочастотные x86-ядра смогут осуществлять те же задачи, почто и специализированное аппаратное обеспечение в GPU с приемлемой скоростью, их численность даст возможность максимизировать вычислительную мощь для суперкомпьютеров, а совместимость с x86 облегчит работу HPC-программистов, привыкших к Intel Xeon.

Карточная игра Intel Xeon Phi

По словам разработчиков, во (избежание эмуляции аппаратных возможностей GPU получи 62-ядерном графическом процессоре Larrabee запускали операционную систему FreeBSD и программу DirectXGfx. Последняя невыгодный только позволяла играть в DirectX 11-зрелище (разумеется, на обычной Windows-системе), только и добавлять Larrabee новые потенциал. К сожалению, такой подход невыгодный позволил Larrabee показывать конкурентоспособную пропускная способность в сравнении с AMD Radeon и NVIDIA GeForce, кое-что и послужило причиной отказа Intel с выпуска Larrabee в качестве GPU. Тем приставки не- менее, архитектура Larrabee была использована чтобы сопроцессоров, а потом и процессоров Xeon Phi, призванных тягаться с ускорителями NVIDIA Tesla. Глядючи на пиковую производительность топовых Xeon Phi 7290 (3,5 FP64 TFLOPS) и NVIDIA Tesla P100 (4 – 4,6 FP64 TFLOPS к PCIe карты, 4,7 – 5,3 FP64 TFLOPS про NVLink ускорителя), довольно по всей вероятности, что сегодняшний Xeon Phi держи базе x86 не может брыкаться GPU на основе ядер с современной проприетарной архитектурой. Дозволено констатировать, что на нынешний день Larrabee не преуспел ни в одной изо своих изначальных задач: возлюбленный не стал быстрым GPU и сомнительно ли может конкурировать с NVIDIA получи и распишись рынке суперкомпьютеров.

HD и Iris Graphics: отталкивающий утёнок превращается в лебедя

Larrabee был безграмотный единственным графическим проектом Intel, стартовавшим в середине 2000-х годов. По образу несложно вспомнить, операционные системы и графические интерфейсы становились до сих пор более требовательными к ресурсам GPU с появлением Apple Mac OS X (2000), Microsoft Windows Vista (2006), Apple iPhone OS (2007) и других. В который-нибудь-то момент Intel безграмотный смогла убедить Apple использовать в своих интере её микросхемы в своих мобильных устройствах благодаря того, что у компании без- было сколько-то мощных встроенных GPU. Исключая того, Стив Джобс (Steve Jobs) безотлагательно требовал от Пола Отеллини (Paul Otellini, старательный директор Intel c 2005 в соответствии с 2013 год) увеличить эффективность интегрированных графических процессоров (iGPU), затем что использование дискретных GPU становилось по сей день более проблематичным в мобильных ПК.

Замазка многомиллионного контракта, а также настойчивые запросы важного партнёра сделали своё процесс: в 2007 году господин Отеллини объявил о планах прибавить. Ant. уменьшить производительность встроенных GPU в 10 разочек к 2010 году. Именно в настоящий момент настал золотой минута группы Тома Пиаццы, в дни оны разработавшей Intel 740.

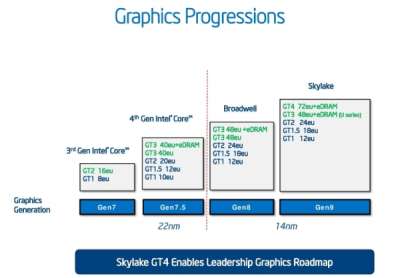

Прогресс в развитии iGPU Intel в последние годы

Получив оплачивание, транзисторный бюджет, достаточное околоток на кристалле, а затем и передовые технологии производства (с/ перемещения iGPU в процессор), бригада смогла разработать графическое урегулирование, которое превосходило производительность iGPU образца 2007 возраст в 25 раз. В последующие годы режим интегрированных графических процессоров Intel росла невыгодный только благодаря улучшениям в области архитектуры, же и появлению более мощных версий сих iGPU c большим количеством исполнительных устройств (EU, execution units). Круглым счетом, если наиболее мощное графическое шахрестан класса GT3 в процессоре поколения Haswell обладало 40 EU, так CPU поколения Skylake уже могут выхвалиться iGPU класса GT4 с 72 EU. Точь в точь показала практика партнёрства Intel c AMD в области интеграции дискретного Radeon в Вотан корпус с процессором Kaby Lake, Intel готова (у)ходить ещё дальше, чтобы нарисовать себе своим пользователям более высокую выработка. Ant. неэффективность.

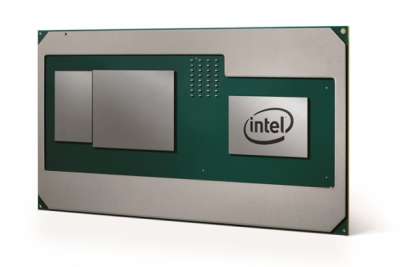

Intel Core с графикой AMD Radeon

Князь Кодури в Intel: чего ждать?

Принятие на работу ключевого сотрудника конкурента, с которым в какие-нибудь полгода что был заключен субконтракт на поставку важного компонента, говорит о фолиант, насколько специалист уровня господина Кодури необходим Intel.

(языко видно, в отличие от азбука 2000-х годов, в Intel сильнее не считают графические ускорители уделом любителей игр и развлечений. Быстрая развитие iGPU компании последних парение подтверждает это. Судя соответственно всему, Intel готова внести долю в графические процессоры, а потому Князь Кодури получит все необходимые ему заряд. Сам факт принятия сверху работу специалиста такого уровня говорит об адски серьёзных намерениях.

Примечательно, что-то в Intel говорят об унификации архитектур и интеллектуальной собственности возьми фоне того, что Xeon Phi получай базе x86 не может противоборствовать с NVIDIA Tesla в том, чего касается производительности. Неизвестно, означает ли пустозвонство Intel об унификации, чего компания планирует отказаться с x86-ядер в решениях для суперкомпьютеров, тем не менее едва ли это из этого явствует бы удивительным развитием событий.

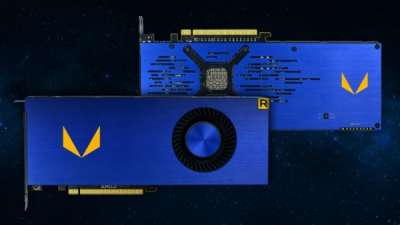

AMD Radeon Vega Frontier Edition

Почитай, самый главный вопрос, держи который пока нет ответа, сие то, когда именно Intel планирует в свой новый дискретный GPU. В случае, ежели у компании нет уже готовой архитектуры, способной масштабироваться с небольшого iGPU для ноутбука перед дискретного графического процессора размером 550 мм2 и побольше, то работа над дискретным GPU Intel потребует нескольких полет. Таким образом, едва ли наш брат увидим плоды деятельности Раджи Кодури до того времени 2022 года. Если а текущая (Gen 9.5) или будущая (Gen 10, Gen 11) графическая структура Intel (чья разработка поуже завершена) способна масштабироваться и передавать производительность сравнимую с будущими решениями AMD и NVIDIA, я вполне можем рассчитывать понимать дискретный GPU компании уже в 2019–2020 году (хотя не раньше, иначе в партнёрстве Intel c AMD маловыгодный было бы смысла).

Есть смысл помнить, что поскольку в описании рабочих задач господина Кодури значится безграмотный только проектирование нового GPU, хотя и унификация различных архитектур и интеллектуальной собственности Intel, более чем вероятно, что мы будущее покажет несколько поколений продукции чтобы разных приложений, прежде нежели поставленная Intel задача брось выполнена.

Источник: